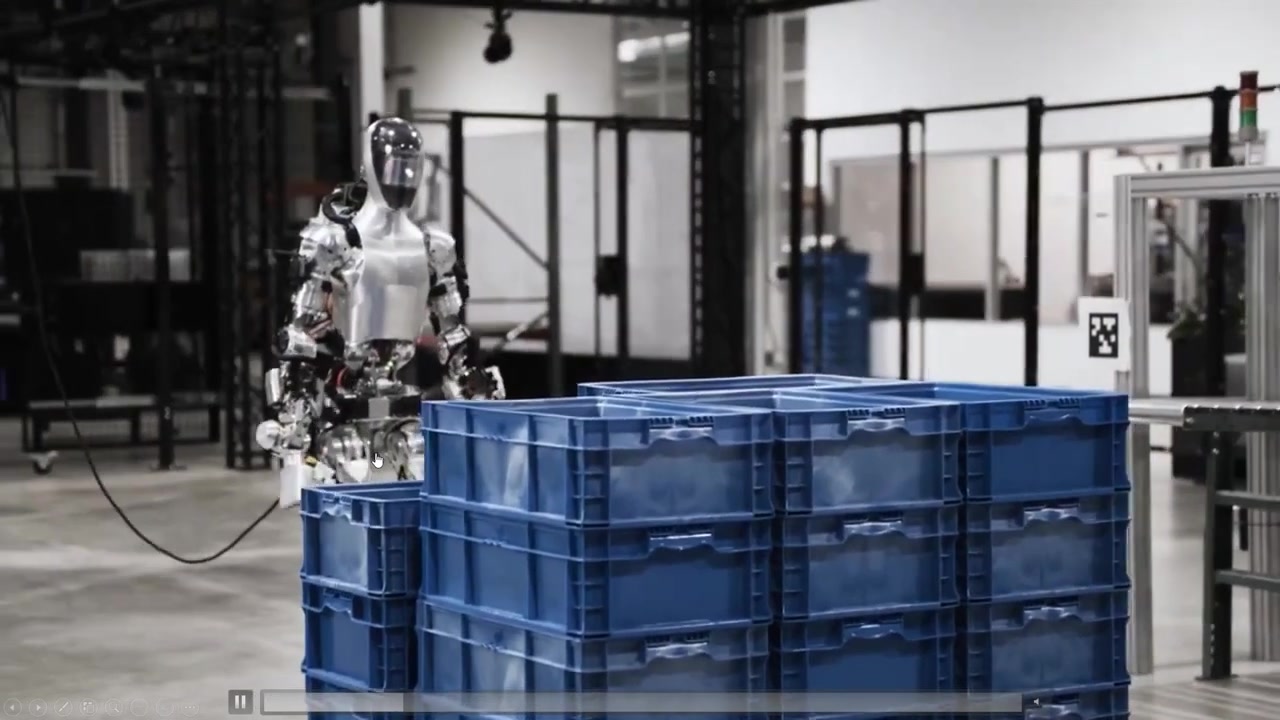

OpenAI는 ChatGPT를 개발한 곳으로 인류에게 이익을 주는 것을 목표로 하는 미국의 인공지능 연구소이다. 최근 AI 로봇 제조 스타트업 Figure 사의 인간형 로봇 Figure 01에 OpenAI의 AI 모델 (GPT)이 탑재 되었으며 이에 대한 데모 영상이 공개 되었다. 이 영상에서 Figure 01은 자체 학습된 비전 모델과 end-to-end 신경망을 활용해 실시간 작업을 수행하며 그와 동시에 대화하는 모습을 보여주고 있다. 이는 멀티 모달 추론 기능과 물건에 대한 인식, 그리고 상호작용 기능 등이 AI 분야의 첨단을 달리고 있다는 것을 보여준다. 이러한 최신 기술 및 발전 속도는 산업 전체에 놀라움과 다양한 영감을 불어 넣고 있다.

이번 글에서는 이 새로운 인간형 로봇이 어떤 놀라움을 우리에게 줄 수 있을지 확인해 볼 예정이다.

출처: OpenAI's NEW "AGI Robot" STUNS The ENITRE INDUSTRY (Figure 01 Breakthrough) - YouTube

1. Figure 01의 놀라운 상호작용 능력

- OpenAI와 Figure사의 협력으로 소개된 새로운 인간형 로봇 Figure 01에 많은 놀라움을 가지게 되었다.

- 로봇들이 전체 대화, 주변 이해, 미리 계획 세우기, 그리고 인간과 같은 정밀한 과제 수행이 가능한 것을 볼 수 있다.

- Figure 01은 데모 영상에서 놀라운 상호작용 능력을 보여주는데, 음식을 달라고 요청하자 사람이 먹을수 있는 것 (영상에서 사과)만 집어서 건네주는 것을 볼 수 있었다.

- Figure 01은 현재 상황을 바탕으로 앞으로의 일을 추론하고 그것이 옳다고 판단하면 행동으로 보여준다.

- Figure 01과의 소통을 통해 상호작용이 성공적으로 이루어졌는지에 대한 의견을 전달하고 Figure 01은 이를 수용하여 자신을 피드백할 수 있다.

2. Figure 01은 과거 보다 빠르게 움직이며 자율적으로 행동한다.

- 과거의 데모 영상들에서 로봇은 속도가 느리기 때문에 이들이 빠르게 보이도록 하는 것이 중요한 마케팅 포인트였다.

- 하지만 현대의 데모는 과거와 달리 모두 실시간 움직임을 보여주고 있으며 Figure 01이 수행하는 모든 행동은 엄격한 훈련 과정을 통해 세밀하게 습득된 학습 행동으로 인간에 의해 원격 조종되지 않았음을 보여준다.

- Figure 01은 자율적으로 동작하는 거대 네트워크에 의해서 추론 하는데 이는 카메라로부터의 이미지와 마이크로폰으로부터 수집된 음성을 처리하는 커다란 멀티 모달 모델을 사용한다.

- 이 모델은 대화의 전체 내용과 과거 이미지를 처리하여 언어 응답을 만들어 냄으로써 Figure 01이 수행할 동작을 결정하고 명령을 실현하는 역할을 맡고 있다.

- Figure 01에게 '지금 무엇을 보고 있지?'라고 물어보면 Figure 01은 중앙 테이블 위에 있는 접시에 빨간 사과, 수저와 접시가 있는 건조대, 그리고 손을 테이블에 올린 채로 근처에 서있는 것을 본다고 대답한다.

3. Figure 01은 주변 환경을 이해하고 있으며, 인상적인 TTS (Text-To-Speach) 기능을 보여준다.

- Figure 01은 사람의 음성으로 명령하면 보유하고 있는 정책 라이브러리에서 무엇을 해야하는지 정책을 결정하고, 추론을 통해 선택한 정책을 실행할 수 있습니다.

- Figure 01은 이미지 (현재 촬영된 장면)를 이해하여 현재 일어나는 일을 추론하거나 다음 단계에 무엇을 해야 하는지 결정할 수 있다.

- 또한 TTS 기능을 통해 인간과 대화할 수 있으며, 어조와 음성이 매우 자연스럽고 인간적이다.

- 최근 소프트웨어 실험에서 100% 인간적인 음성이 가능하다는 것을 증명하였다.

4. Fiugre 01은 주변 환경을 판단하고 상식적인 결정을 내리는 새로운 능력을 보여준다.

- Corey (개발자)가 공유한 X (구 트위터)에 따르면, Figure 01은 멀티 모달 모델 통합으로 시각과 텍스트 정보를 이해하고 처리하는 것이 가능해졌다.

- 이로써 Figure 01은 주위 환경을 상세히 묘사할 뿐만 아니라 세밀한 이해로 일상 상황을 해석함으로써 모호하고 맥락에 따른 요청에 대한 행동을 수행할 수 있게 되었다.

- "배고파"와 같은 모호하고 맥락에 대한 이해가 필요한 요청에 대해 사람에게 사과를 건내주는 등 맥락에 맞는 행동으로 변환하여 수행하며 이 행동을 하게된 추론에 대한 설명도 제공한다.

- Figure 01은 상식적인 추론을 통해 의사결정을 내리는 능력을 보여주며, 주변 환경을 스캔하여 행동을 선택하고 수행함으로써 고급 추론 능력을 보여준다.

- 이는 Figure 01이 듣고 대답할 뿐만 아니라 계획을 세우고 논리적으로 설명하는 능력을 가져 인간 협업자와 같은 행동을 가능하게 한다는 점에서 충분히 놀라운 능력이다.

- 또한 Corey는 대화 기록을 이해하는 large pre-train 모델이 Figure 01에게 단기 기억력을 제공하고 있으며 이를 통해 대화의 이미지와 텍스트 기록을 분석하며, 곧바로 계획을 실행할 수 있다고 한다.

- 영상에서 Figure 01은 "앞에 있는 접시와 컵은 어디에 있어야 할까?" 라는 질문에 "건조대에 있어야 할 가능성이 높다"고 대답하며, 이에 "거기에 담아줄 수 있느냐?" 라는 요청에 건조대에 컵과 접시를 두는 작업을 수행한다.

- Figure 01이 가진 "주위 환경을 관찰하여 다음에 일어날 일을 추측하는 상식적 추론 능력"은 이전에 본 것보다 한 단계 발전된 추론 능력이라는 것을 알 수 있다.

5. Figure 01의 정밀한 손 동작과 시각 정보처리 시연

- Figure 01이 두 손을 활용해 물건 다루고 조작하는 것을 "매뉴얼 조작 (manual manipluation)"이라 정의 하였으며 이를 위해 신경망 비주얼 Moto Transformer 정책이 중요하다.

- 기본적으로 Figure 01의 두뇌에는 카메라를 통해 사진을 찍을 수 있는 부분이 있으며, 팔이나 손가락을 움직이는 동작으로 직접 변환할 수 있는 부분이 있다고 예상할 수 있다.

- 이를 위해 Transformer 모델을 사용하는데 이는 일련의 데이털르 처리하는데 능숙한 신경망으로 Figure 01은 이를 이용하여 시간에 따른 일련의 이미지를 처리 한다.

- 즉 시각 정보를 해석하여 손과 손가락이 취해야할 동작을 결정한다.

- Figure 01은 초당 10번의 이미지를 촬영하고 그에 따라 1초에 200번의 행동을 수행하며, 시각과 행동 간의 미세한 지연이 있지만 인간의 인지보다는 빠르게 처리된다.

6. Figure 01의 복잡한 움직임과 그에 따른 몸체 조율

- 24 자유도 액션 (24 degrees of freedom actions)은 본질적으로 로봇 공학에서 로봇이 얼마나 다양한 방식으로 움직일 수 있는지를 의미하며 이 영상에서는 Figure 01이 그것을 제어할 수 있다는 것을 보여준다.

- 손목 위치 및 손가락 각도를 24가지 독특한 방식으로 파악하고 조작하며, 전신 제어에 대한 높은 설정값도 제공한다.

- 이는 Figure 01은 손의 행동과 관심사를 분리할 수 있다는 것을 보여준다.

- 이것은 복잡한 문제를 더 작고 관리하기 쉬운 부분으로 나누는 것을 의미하는 '관심 분리'이며, 이 경우 인터넷의 사전 학습된 모델은 Figure 01의 상위 레벨 사고처럼 작동한다.

- 그리고 보고 듣는 것을 기반으로 계획을 세우는 감각과 학습된 시각적 운동 정책은 Figure 01의 반사 작용으로 동작하여 예측할 수 없는 물체의 움직임에 적응하는 것과 같은 복잡한 작업을 수행할 수 있다.

- Figure 01의 두뇌의 여러 부분은 작업의 다양한 측면에 집중할 수 있도록 하며 전신 제어 기능은 균형 감각 및 자기 보존을 통해 Figure 01이 안정적으로 자세를 유지하거나 위험하게 움직이지 않도록 한다.

7. 빠르고 인간적인 반응을 위해 AI 대화 모델로 GPT 최신 모델을 사용하다.

- AI 대화 모델로 OpenAI의 GPT 최신 모델을 사용하였다.

- 향후 업데이트에서 Chat GPT 4.5 및 GPT 5가 언급됐으며, 반응 속도를 향상과 더 나은 상호작용을 위해 지속적인 모델 업데이트는 필수적인 것으로 보인다.

- 다만 일반인이 온라인이나 애플리케이션에서 사용하는 GPT와 Figure 01과 같은 로봇들이 사용하는 GPT는 다른 시스템으로 고려되는데 로봇의 경우 사람과 상호작용 하려면 굉장히 적은 지연시간을 가져야 하기 때문이다.

8. Figure 01의 자연스러운 움직임에 놀랐으며 미래 전망이 기대된다.

- Figure 01이 접시를 부드럽게 움직여 건조대 안에 놓는 것과 휴지통을 비우는 동작이 매우 자연스럽고 인간적으로 느껴졌다.

- Figure 01이 휴지통을 옮긴 후 바구니를 다시 사람에게 가져다주는 행동도 매우 인간적으로 느껴져 놀랍게 느껴졌다.

- 이로인해 앞으로 회사가 어디로 향할 지에 대한 미래 전망이 흥미롭다고 생각했다.

- 로봇의 능동성과 속도가 증가하며 자동화 기술 발전의 가능성에 대해 더욱 충격을 받았다.

- 로봇이 환경을 인식하고 환경에 대해 이해할 수 있는 능력을 키우는 중이지만, 다음 단계에서는 다리의 속도에 대해 조율할 것으로 예상된다.

- 당초 속도가 느린 것으로 보였던 다리 속도에 대한 개선이 많이 진행되고 있으며, 동적 환경에서 정책을 업데이트하는 로봇이 흥미롭게 변화될 것으로 전망된다.

- 이 팀이 신속한 발전을 이끌고 있어 연말까지 인간 속도에 근접한 대화 능력을 갖출 것으로 예상되며, 동적 환경에서 정책을 동적으로 조정하는 시나리오가 매력적일 것으로 보인다.

반응형

'IT와 개발 > AI 이야기' 카테고리의 다른 글

| Command R+: GPT-4 Turbo의 대항마가 될까? (0) | 2024.04.23 |

|---|---|

| 2024년 MAD (Machine Learning, AI, Data) 생태계 (1) | 2024.04.16 |

| OpenAI: 프롬프트 엔지니어링 (1) | 2024.04.09 |

| OpenAI의 GPT4.5 유출 소문 (1) | 2024.04.02 |

| 베네딕트 에반스가 바라본 2024년 기술 트렌드 (4) | 2024.03.15 |